IA générative : la consommation énergétique explose

- La consommation énergétique de l’intelligence artificielle explose avec l’engouement pour l’IA générative, bien que les données fournies par les entreprises manquent.

- Les interactions avec des IA comme ChatGPT pourraient consommer 10 fois plus d’électricité qu’une recherche Google classique, d’après l’Agence internationale de l’énergie.

- En 2026, la hausse de la consommation électrique des centres de données, des cryptomonnaies et de l’IA pourrait s’élever à l’équivalent de la consommation électrique de la Suède ou de l’Allemagne, par rapport à 2022.

- L’empreinte carbone de l’IA est loin d’être négligeable, ainsi, des scientifiques estiment que l'entraînement du modèle d'IA BLOOM émet 10 fois plus de gaz à effet de serre qu’un Français en une année.

- Il semble complexe de réduire la consommation énergétique de l’IA, rendant essentielle la promotion de sa sobriété pour l’avenir.

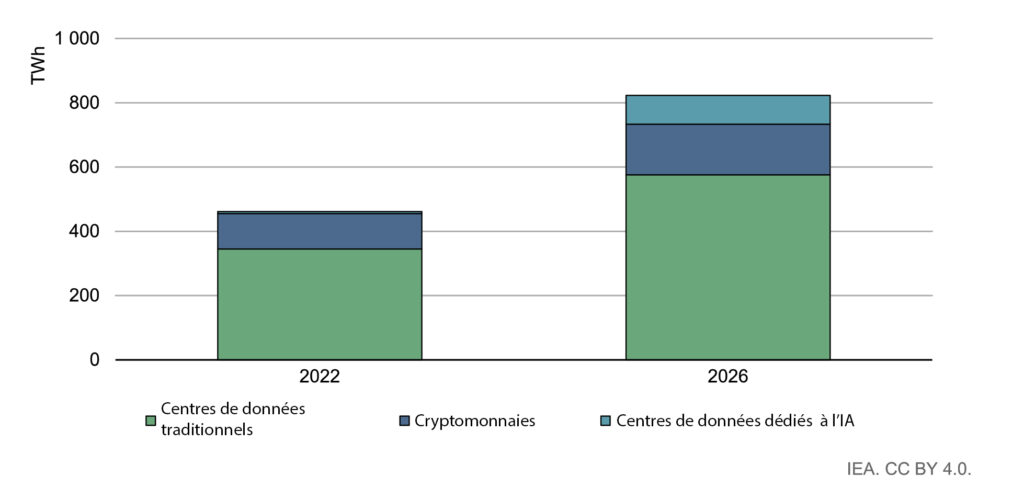

L’intelligence artificielle (IA) s’est immiscée dans de très nombreux secteurs : médical, numérique, bâtiments, mobilité… Définie comme la « capacité d’un ordinateur à automatiser une tâche qui nécessiterait normalement le discernement humain1 », l’intelligence artificielle a un coût : son déploiement massif engendre des besoins croissants en énergie. Les tâches informatiques nécessaires à la mise en œuvre de l’IA requièrent l’usage de terminaux utilisateurs (ordinateurs, téléphones, etc.) et surtout de centres de données. On en recense actuellement plus de 8 000 à travers le monde, dont 33 % se situent aux États-Unis, 16 % en Europe et près de 10 % en Chine d’après l’Agence internationale de l’énergie2 (AIE). Les centres de données, les cryptomonnaies et l’intelligence artificielle représentent presque 2 % de la consommation électrique mondiale en 2022, soit une consommation électrique de 460 TWh. En comparaison, la consommation électrique française s’est élevée à 445 TWh en 20233.

La consommation d’électricité de l’IA : un manque de données ?

Quelle part de cette consommation électrique est réellement dédiée à l’IA ? « Nous ne le savons pas exactement, répond Alex de Vries. Dans un cas idéal, nous utiliserions les données fournies par les entreprises qui utilisent l’IA, notamment les GAFAM qui sont responsables d’une large part de la demande. » En 2022, Google fournit pour la première fois des informations sur le sujet4 : « Le pourcentage [d’énergie utilisée] pour l’apprentissage automatique s’est maintenu au cours des trois dernières années, représentant moins de 15 % de la consommation totale d’énergie de Google. » Pourtant, dans son dernier rapport environnemental5, l’entreprise ne fournit aucune donnée précise sur l’intelligence artificielle. Seule la consommation totale d’électricité de ses centres de données est indiquée : 24 TWh en 2023 (contre 18,3 TWh en 2021).

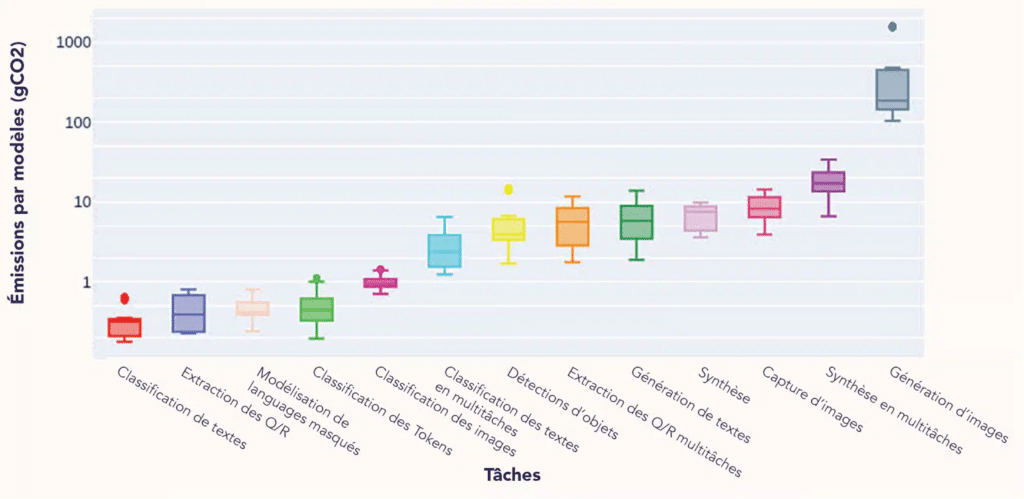

Faute de données fournies par les entreprises, la communauté scientifique tente d’estimer la consommation électrique de l’IA depuis quelques années. En 2019, un premier article6 jette un pavé dans la mare : « Le développement et l’entrainement de nouveaux modèles d’IA sont coûteux, tant sur le plan financier […] qu’environnemental, en raison de l’empreinte carbone liée à l’alimentation des équipements. » L’équipe estime que l’empreinte carbone de l’entrainement total pour une tâche donnée de BERT, un modèle de langage développé par Google, équivaut environ à celle d’un vol transatlantique. Quelques années plus tard, les scientifiques de Google jugent que ces estimations surestiment de 100 à 1 000 fois l’empreinte carbone réelle. De son côté, Alex de Vries a choisi de s’appuyer sur les ventes d’équipements dédiés à l’IA7. La société NVIDIA domine le marché des serveurs dédiés à l’IA – elle représente 95 % des ventes. En se basant sur les ventes et la consommation des serveurs, Alex de Vries projetait une consommation électrique atteignant 5,7 à 8,9 TWh en 2023, un chiffre faible au regard de la consommation mondiale des centres de données (460 TWh).

La révolution de l’IA générative

Mais ces chiffres pourraient exploser. Alex de Vries estime qu’en 2027, si les capacités de production correspondent aux promesses des firmes, les serveurs NVIDIA dédiés à l’IA pourraient consommer 85 à 134 TWh d’électricité chaque année. En cause : l’explosion de l’utilisation de l’IA générative. ChatGPT, Bing Chat, Dall‑E, etc. : ces intelligences artificielles générant du texte, des images ou encore des conversations ont pénétré le secteur à une vitesse record. Or ces IA nécessitent beaucoup de ressources de calcul et sont donc très consommatrices en électricité. Les interactions avec des IA comme ChatGPT pourraient consommer 10 fois plus d’électricité qu’une recherche Google classique d’après l’AIE. Ainsi, si toutes les recherches Google – 9 milliards chaque jour – s’appuyaient sur ChatGPT, 10 TWh d’électricité supplémentaires seraient consommés chaque année. Alex De Vries estime la hausse à 29,3 TWh par an, autant que la consommation électrique de l’Irlande. « La hausse continue de la consommation énergétique, et donc de l’empreinte carbone de l’intelligence artificielle est un phénomène très bien connu, commente Anne-Laure Ligozat. Les modèles d’IA sont de plus en plus complexes : plus ils comportent de paramètres, plus les équipements tournent longtemps. Et comme les machines sont de plus en plus puissantes, cela pousse à faire des modèles de plus en plus complexes... » L’Agence internationale de l’énergie estime pour sa part qu’en 2026, la hausse de la consommation électrique des centres de données, des cryptomonnaies et de l’IA pourrait s’élever entre 160 et 590 TWh par rapport à 2022. Soit l’équivalent de la consommation électrique de la Suède (estimation basse) ou de l’Allemagne (estimation haute).

Les besoins en calcul de l’IA s’expliquent par différentes phases. Le développement d’une IA passe par une première phase d’apprentissage sur des bases de données, c’est la phase d’entrainement. Une fois le modèle prêt, il peut être utilisé sur de nouvelles données : c’est la phase d’inférence10. La phase d’entrainement a focalisé l’attention des scientifiques pendant longtemps, étant la plus consommatrice en énergie. Mais les nouveaux modèles d’IA ont changé la donne, comme en témoigne Alex de Vries : « Avec l’adoption massive des modèles d’IA comme ChatGPT, tout s’est inversé et la phase d’inférence est devenue prépondérante. » Les récentes données fournies par Meta et Google indiquent qu’elle représente de 60 à 70 % de la consommation énergétique, contre 20 à 40 % pour l’entrainement11.

La neutralité carbone : mission impossible pour l’IA ?

Alors que la consommation énergétique de l’IA est entachée d’incertitudes, estimer son empreinte carbone relève du défi pour la communauté scientifique. « Nous sommes en mesure d’évaluer l’empreinte liée à la consommation dynamique de l’entrainement, celle liée à la fabrication des équipements informatiques, mais il reste compliqué d’évaluer l’empreinte totale liée à l’utilisation. Nous ne connaissons pas le nombre précis d’utilisations, ni la part d’utilisation dédiée à l’IA sur les terminaux employés par les utilisateurs, souligne Anne-Laure Ligozat. Pourtant, des collègues viennent de mettre en évidence que l’empreinte carbone des terminaux utilisateurs n’est pas négligeable : elle est de l’ordre de 25 à 45 % de l’empreinte carbone totale de certains modèles d’IA. » Anne-Laure Ligozat et son équipe estiment que l’entrainement du modèle d’IA BLOOM – un modèle en accès libre – émet de l’ordre de 50 tonnes de gaz à effet de serre, soit 10 fois plus que les émissions annuelles d’un Français. Dès lors, difficile pour les géants de la tech d’atteindre leurs objectifs de neutralité carbone, malgré les nombreuses mesures de compensation prises. Google reconnait dans son dernier rapport environnemental : « En comparaison avec 2022, nos émissions […][de 2023] ont augmenté de 37 % malgré les efforts considérables et les progrès concernant les énergies renouvelables. Cela s’explique par la consommation d’électricité de nos centres de données, qui dépasse notre capacité à développer des projets d’énergie renouvelables. »

Limiter le réchauffement climatique implique une réduction drastique des émissions mondiales de gaz à effet de serre. L’IA se trouve-t-elle dans une impasse ? « Aucun argument avancé par Google pour réduire les émissions de l’IA ne tient la route, déplore Anne-Laure Ligozat. L’amélioration des équipements impose d’en fabriquer de nouveaux, émettant ainsi des GES. L’optimisation des infrastructures – comme le refroidissement à l’eau des centres de données – déplace le problème sur la ressource en eau. Et la délocalisation des centres de données vers des pays avec un mix électrique bas carbone nécessite d’être en mesure de gérer la demande électrique supplémentaire… » Quant à l’optimisation des modèles, si elle réduit effectivement leur consommation, elle pousse à une utilisation accrue… le fameux effet rebond. « Cela tend à annuler les économies d’énergie possibles, conclut Alex de Vries. Je plaide principalement pour la sobriété des usages de l’IA. »