Comment l’IA pourrait humaniser les robots

- Les grands modèles de langage (LLM) et les modèles vision-langage auront un impact important sur le futur de la robotique.

- Les robots peuvent désormais communiquer en langage naturel, décomposer des tâches en étapes ou encore raisonner à l’aide d’images.

- Cependant, les LLM ne permettent pas efficacement aux robots de manipuler leur environnement avec les mains ou d’interagir avec un univers en 3D.

- Des potentialités de développement de la robotique à l’aide de l’IA générative existent, comme celle pour le robot de raisonner en vidéo et en action.

En regardant les vidéos publiées par des entreprises de robotique telles que Tesla et Figure, on pourrait croire que les robots seront présents demain dans nos maisons, capables d’exécuter n’importe quelle commande formulée par un humain grâce aux progrès réalisés avec les grands modèles de langage (LLM). C’est peut-être le cas, mais il y a d’abord des obstacles importants à franchir, explique Edward Johns, directeur du Robot Learning Lab à l’Imperial College de Londres.

Nous avons assisté à des progrès stratosphériques dans le domaine des grands modèles de langage. Cela va-t-il donner un coup de fouet à la robotique ?

Edward Johns. Ce qui s’est passé avec les grands réseaux neuronaux, tels que les modèles de langage et les modèles de vision-langage, aura un impact important sur la robotique. Ces modèles nous aident déjà à relever certains des défis auxquels nous étions confrontés. Mais nous n’allons certainement pas assister du jour au lendemain à l’émergence d’un équivalent de ChatGPT dans le domaine de la robotique.

Les LLM permettent aux opérateurs de communiquer avec le robot en langage naturel plutôt que d’entrer du code. C’est utile car, en fin de compte, c’est ainsi que nous voulons que les humains interagissent avec eux. Plus important encore, ces modèles peuvent ouvrir une nouvelle voie de raisonnement pour les robots : ChatGPT, par exemple, peut décomposer les tâches en étapes. Ainsi, si vous lui demandez comment faire un sandwich, il vous répondra : vous avez besoin de pain, vous devez acheter du pain, vous devez trouver un magasin, prendre votre portefeuille, quitter la maison, etc. Cela signifie que les robots peuvent apprendre à décomposer les tâches en interne, et nous savons qu’ils sont plus performants lorsqu’ils disposent d’un guide étape par étape.

Au cours des derniers mois, nous avons également assisté à l’émergence de ce que l’on appelle les « modèles vision-langage », qui permettent au robot de raisonner non seulement en langage, mais aussi en images. Cette avancée est importante car, à un moment donné, les robots ont besoin d’ajouter des informations visuelles à leur raisonnement pour naviguer dans leur environnement.

Quelle est donc la limite de l’utilisation des LLM pour les robots ?

Bien qu’il s’agisse de modèles intéressants à étudier, ils résolvent certains des défis les plus faciles à relever dans le domaine de la robotique. Ils n’ont pas eu un impact énorme en termes de manipulation dextre, par exemple, c’est-à-dire de manipulation avec les mains. Or, il s’agit d’un problème de la robotique qui est encore vraiment difficile à résoudre. Nos mains accomplissent des milliers et des milliers de tâches complexes chaque jour.

L’un des problèmes est que si ces modèles de langage de vision sont très bons d’un point de vue sémantique, ils ne pourront cependant pas aider le robot à interagir avec un environnement 3D, parce qu’ils ont été formés sur des images 2D. Pour que les robots puissent raisonner à ce niveau, ils ont besoin d’une énorme quantité de données robotiques, qui n’existent tout simplement pas. Certains pensent qu’elles émergeront très rapidement, comme la poudrière que nous avons eu depuis l’émergence de ChatGPT – c’est en tout cas ce que nous entendons dans les communautés de startups. Mais dans le cas de ChatGPT, les données existaient déjà en ligne. Il faudra donc beaucoup de temps pour compiler ces données dans le champ de la robotique.

Le type d’avancées que l’on peut observer chez les entreprises leaders dans le domaine de la robotique, comme Tesla et Figure, est très impressionnant. Par exemple, Figure propose des démonstrations vidéo intéressantes dans lesquelles quelqu’un converse avec un robot qui effectue des tâches avec ses mains. Mais ces robots doivent encore être entraînés à effectuer des tâches spécifiques à l’aide d’approches d’apprentissage automatique telles que l’apprentissage par renforcement, qui consiste à dire au robot d’effectuer une tâche et à lui indiquer s’il y parvient après quelques essais.

Les robots ne pourraient-ils pas rassembler les données dont ils ont besoin et les compiler avec les informations qu’ils apprennent des LLM ?

Je pense que c’est ce sur quoi certains parient. Pouvons-nous laisser les robots collecter eux-mêmes ces données – c’est-à-dire les laisser dans une pièce pendant une nuit avec une tâche et des objets – et voir ce qu’ils ont appris pendant la nuit ? Ce type de raisonnement est utilisé dans l’apprentissage par renforcement, et la communauté s’est précédemment éloignée de cette approche après avoir réalisé qu’elle générait des résultats frustrants qui n’allaient nulle part. Mais nous pourrions assister à un revirement dans le contexte de ces modèles vision-langage.

La robotique peut encore faire l’objet de découvertes scientifiques. Je pense qu’il y a encore beaucoup de travail à faire. Par exemple, j’essaie de faire en sorte que les robots apprennent une tâche en quelques minutes et avec un enseignant non expert.

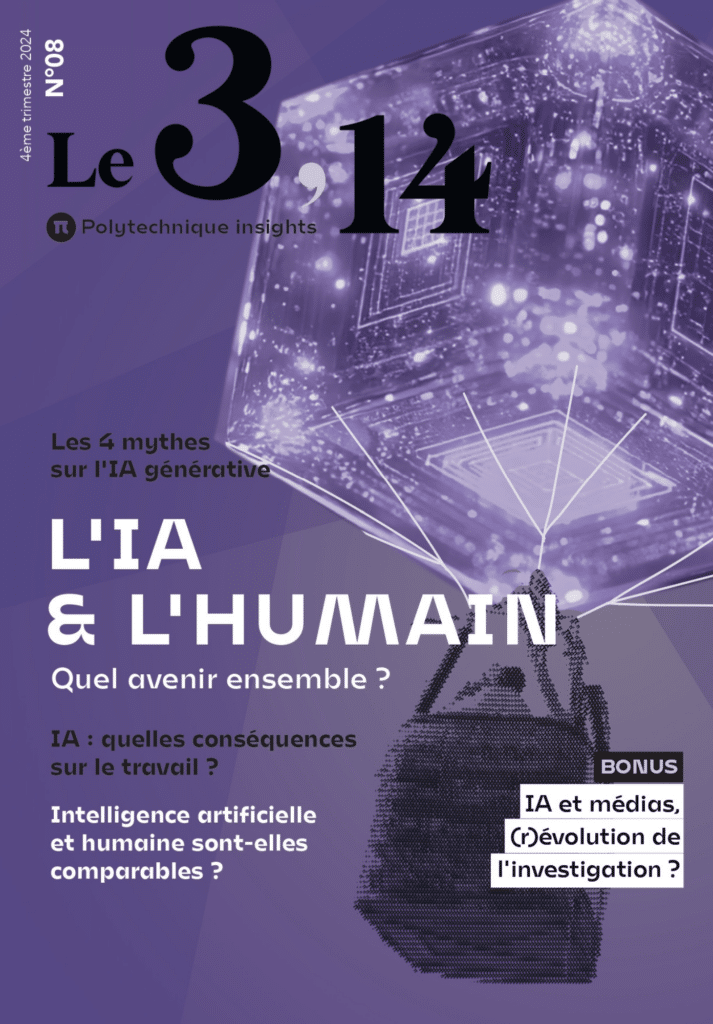

Découvrez le numéro de notre magazine Le 3,14 dédié à l’IA. Disponible ici

Pensez-vous que les LLM et les modèles vision-langage en robotique ne seront qu’un feu de paille ?

Je ne pense pas que ce soit le cas. Il est vrai que ces nouvelles approches n’ont eu qu’un impact mineur en robotique par rapport aux méthodes plus anciennes. Toutefois, si l’ingénierie classique a atteint un certain point de saturation, les modèles de langage de vision s’amélioreront avec le temps.

Si nous nous projetons dans l’avenir, par exemple, nous pourrions voir des modèles d’IA générative produire une vidéo prédisant les conséquences de ses actions. Si nous parvenons à ce stade, le robot pourra commencer à raisonner en vidéo et en action – il y a là un grand potentiel pour la robotique.