IA : pourquoi il faut ouvrir la boîte noire

Plus les algorithmes d’IA se diffusent, plus leur opacité questionne. Dans les Facebook files, ces documents internes que Frances Haugen, spécialiste des classements algorithmiques, a emportés avec elle en quittant l’entreprise, pour ensuite les transmettre au régulateur et au Congrès américain, se dessine un système algorithmique devenu tellement complexe qu’il échappe à la maîtrise des ingénieurs mêmes qui l’ont développé. Alors que le rôle du réseau social dans la propagation de contenus dangereux et de fake news inquiète, l’incapacité de ces ingénieurs, parmi les meilleurs au monde dans leur domaine, à comprendre le fonctionnement de leur création interpelle. L’affaire braque à nouveau les projecteurs sur les problèmes posés par l’(in)explicabilité de ces algorithmes qui prolifèrent dans de nombreuses industries.

Comprendre « les algorithmes opaques »

L’opacité des algorithmes ne concerne certes pas la totalité d’entre eux. Elle est surtout caractéristique des algorithmes dits apprenants (machine learning), notamment du deep learning tel que les réseaux de neurones. Cependant, face à la place croissante que ces algorithmes prennent dans nos sociétés, il n’est pas surprenant que le souci de leur explicabilité — de notre capacité à pouvoir comprendre leur fonctionnement — mobilise régulateurs et comités d’éthique.

Comment pourrions-nous faire confiance à des systèmes à qui nous allons confier nos vies, par exemple pour la conduite de nos véhicules ou le diagnostic d’une maladie grave, si nous ne les comprenons pas ? Et, plus largement, le devenir de nos sociétés par les informations qui circulent, les idées politiques qui se propagent, les discriminations qui s’y cachent ? Comment attribuer la responsabilité d’un accident ou d’un effet secondaire nocif s’il n’est pas possible d’ouvrir la « boîte noire » ?

Au sein des organisations qui développent et utilisent ces algorithmes opaques, cette quête de l’explicabilité entremêle au fond deux enjeux, qu’il est utile de distinguer. Il s’agit d’une part d’expliquer pour comprendre (interpretability), dans le but d’améliorer l’algorithme, parfaire sa robustesse et prévoir ses failles. D’autre part, expliquer pour rendre compte (accountability) du fonctionnement du système aux multiples parties prenantes, externes (régulateurs, utilisateurs, partenaires) ou internes à l’organisation (managers, chefs de projet). Cette accountability est cruciale pour que la responsabilité des effets — bons et moins bons — de ces systèmes puisse être attribuée et assumée.

Ouvrir « la boîte noire »

Tout un champ de recherche se développe donc aujourd’hui pour tenter de répondre au challenge technique d’ouvrir la « boîte noire » de ces algorithmes : l’Explainable Artificial Intelligence (XAI). Mais est-ce suffisant de rendre transparent ces systèmes pour répondre à ce double enjeu de l’explicabilité : interpretability et accountability ? Dans notre discipline, les sciences de gestion, des travaux s’interrogent en effet sur les limites de la transparence. Nous avons alors étudié la manière dont les individus au sein des organisations s’emparent des outils d’explication qui ont été développés tels les cartes de chaleur1, ainsi que des courbes de performance2, souvent associées à ces outils dans une démarche d’appréhension de ces algorithmes. Nous avons cherché à comprendre les jeux organisationnels qu’ils suscitent.

En effet, ces deux types d’outils semblent aujourd’hui en voie de standardisation pour répondre à la pression des régulateurs d’expliquer les algorithmes, pression illustrée par l’article L4001‑3 du code de la santé publique : « III.-Les concepteurs d’un traitement algorithmique… s’assurent de l’explicabilité de son fonctionnement pour les utilisateurs » (loi n° 2021–1017 du 2 août 2021). Nos premiers résultats mettent en lumière les tensions qui se nouent au sein des organisations autour de ces outils. Prenons deux exemples caractéristiques.

Exemple #1 : Expliquer le raisonnement ou une décision particulière ?

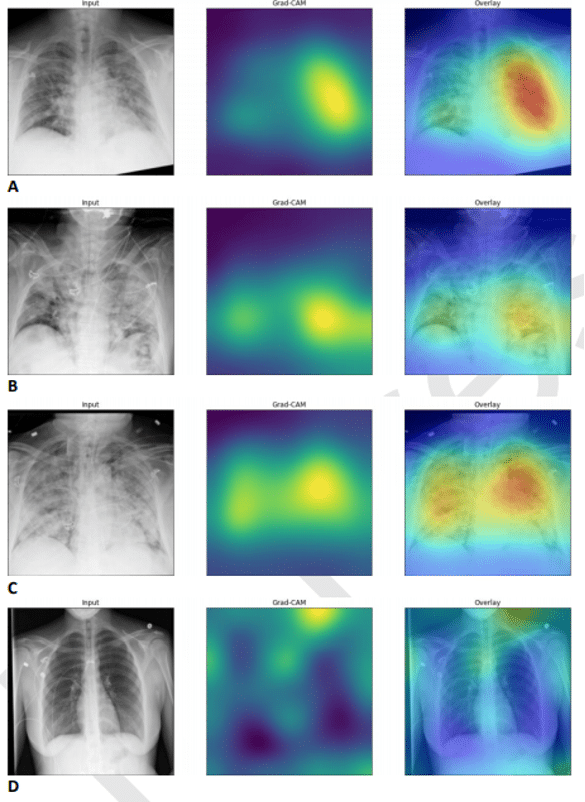

Le premier exemple illustre les ambiguïtés de ces outils lorsqu’ils sont utilisés dans des contextes organisationnels, par des experts métier qui ne les maîtrisent pas. La figure 1, extraite de Whebe et al. (2021), reproduit des cartes de chaleur utilisées pour expliquer le fonctionnement d’un algorithme développé pour détecter le Covid-19 à partir de radiographies des poumons. Ce système affiche dans les tests une très bonne performance, comparable, et souvent meilleure, à celle d’un radiologue humain. En étudiant ces images, on note que dans les cas A, B, et C, ces cartes de chaleur nous indiquent que l’IA s’est prononcée à partir d’une zone correspondant aux poumons. Dans le cas D, la zone illuminée est cependant située autour de la clavicule du patient.

Cette observation met en lumière un problème souvent retrouvé dans notre étude sur l’usage de ces outils dans les organisations : pensés par les développeurs pour repérer des raisonnements inadéquats de l’IA, ces outils sont souvent, dans la pratique, utilisés pour se prononcer sur la validité d’un cas particulier. Or ces cartes de chaleur ne sont pas conçues pour cela, et pour un utilisateur final, ce n’est pas la même chose de dire : « le diagnostic de cette IA semble précis » ou « le processus par lequel elle procède pour déterminer son diagnostic semble valide ».

Deux problèmes sont alors mis en exergue : premièrement se pose la question de la formation des utilisateurs, non seulement à l’IA, mais aussi aux fonctionnements de ces outils d’explication. Et plus fondamentalement, cet exemple questionne sur les usages de ces outils en matière d’attribution de la responsabilité d’une décision : en les diffusant, on risque d’amener les utilisateurs à engager leur responsabilité à partir d’outils qui sont détournés de leur usage premier. Autrement dit, ces outils, créés pour un usage d’interpretability, risquent d’être mobilisés dans des situations où l’enjeu est de rendre compte (accountability).

Exemple #2 : Expliquer la performance ou l’évaluer

Un deuxième exemple permettra d’illustrer les effets équivoques des jeux organisationnels qui se nouent autour d’outils d’explication comme les courbes de performances. Un développeur travaillant dans le secteur de la publicité sur internet nous confia que, dans son domaine, si la performance de l’algorithme n’atteignait pas plus de 95 %, les clients n’achetaient pas la solution. Cette norme avait des effets concrets sur les processus d’innovation : elle poussa son entreprise, sous la pression des commerciaux, à choisir de commercialiser et focaliser ses efforts de R&D sur un algorithme très performant, mais peu explicable. Ce faisant, elle abandonna le développement d’un autre, plus explicable, mais qui n’atteignait pas ce niveau de performance.

Le problème est que l’algorithme retenu — contrairement à celui qui fut écarté — n’était pas capable de gérer des changements radicaux d’habitudes de consommation, comme durant le Black Friday, poussant l’entreprise à ne pas recommander à ces clients d’engager de campagne marketing à cette période, car il était difficile de reconnaître que la performance de l’algorithme chutait. Là encore, l’outil est dévoyé : au lieu d’être utilisées comme un élément parmi d’autres pour faire le choix du meilleur algorithme pour une activité donnée, ces courbes de performances étaient utilisées par les acheteurs pour justifier le choix d’un prestataire par rapport à une norme sectorielle — c’est-à-dire de pour rendre des comptes.

L’interaction « hommes-machines-organisation »

Pour nous, chercheurs en sciences de gestion, intéressés par les processus de prise de décision et d’innovation, le rôle des outils pour les épauler, et la manière dont les acteurs légitiment les choix qu’ils font au sein de leurs organisations, ces deux exemples montrent qu’il ne suffit pas de regarder ces outils computationnels de manière isolée. Ils appellent à aborder les algorithmes, leurs contextes humains, organisationnels et institutionnels comme des assemblages. Tenir un tel assemblage responsable exige alors de ne pas se contenter de voir à l’intérieur de l’un de ses composants comme l’algorithme — tâche ardue et indispensable — mais nécessite de comprendre comment l’assemblage fonctionne en tant que système, composé de machines, d’humains et d’organisation. Et, par conséquent, de se méfier d’une trop rapide standardisation des outils d’explicabilité, dont résulteraient des systèmes hommes-machines-jeux organisationnels, dans lesquels l’impératif de rendre des comptes se substituerait à celui d’interpréter, multipliant les boîtes noires dont l’explicabilité ne serait qu’une façade.