Tricher ou “chatter” : ChatGPT est-il une menace pour l’éducation ?

- ChatGPT est un chatbot, c’est-à-dire un programme informatique conçu pour simuler une conversation avec un humain, qui produit des textes convaincants et naturels.

- Le corps enseignant s’interroge donc sur les risques relatifs à l’utilisation des chatbots par les étudiants, qui peuvent demander à ChatGPT d’écrire leurs dissertations, par exemple.

- Des outils existent pour savoir si un texte a été rédigé par un chatbot ou non, mais il est actuellement impossible d’en être sûr à 100 %.

- Pour identifier si un texte a été généré par une IA, il est possible de traquer les formulations étranges, une syntaxe peu naturelle, ou les occurrences de plagiat.

- Avec le bon encadrement, les chatbots peuvent néanmoins devenir de puissants alliés pour enseigner et étudier, mais aussi pour le monde professionnel.

Que ce soit pour le service client, le marketing, les jeux vidéo ou l’apprentissage en ligne, les « chatbots » sont couramment utilisés depuis plusieurs dizaines d’années12. Le tout premier chatbot, ELIZA, développé dans les années 1960 au Laboratoire d’intelligence artificielle du MIT, a été pensé pour simuler un psychothérapeute, en utilisant un traitement de langage naturel pour répondre aux questions de l’utilisateur. Aujourd’hui, près de soixante ans plus tard, les chatbots deviennent de plus en plus sophistiqués, utilisant l’IA pour comprendre les données saisies par l’utilisateur, ce qui permet de produire des conversations plus naturelles et plus intelligentes. Plus la technologie progresse, plus les chatbots sont susceptibles de devenir encore plus perfectionnés, générant des conversations encore plus fluides et personnalisées dans divers secteurs, en passant de la santé jusqu’à la finance3.

ChatGPT, mis en service le 30 novembre 2022, est un chatbot – c’est-à-dire un programme informatique conçu pour simuler une conversation avec un humain – développé par l’entreprise OpenAI, basée à San Francisco. Comme son nom anglais l’indique, ChatGPT est fondé sur le GPT (Generative Pre-Trained Transformer, ou « Transformeur génératif pré-entraîné »), un type de modèle d’intelligence artificielle (IA) entraîné à partir de grandes quantités de données textuelles et utilisé pour générer des réponses textuelles aux questions de ses utilisateurs. Si ChatGPT gagne actuellement en popularité, c’est grâce à sa capacité à produire des réponses attrayantes et convaincantes dans un langage naturel, ce qui en fait un outil utile et facile à utiliser pour autant de tâches comme la création de contenu, le service client automatique ou encore le traitement automatique des langues (Natural Language Processing)4. De ce fait, le corps enseignant s’interroge sur les risques relatifs à l’utilisation des chatbots par les étudiants. De plus, depuis à peine quelques jours OpenAI a mis en service GPT‑4, le successeur de ChatGPT. Il reste à voir à quel point cette nouvelle version est plus avancée que la précédente.

Les étudiants peuvent-ils utiliser les chatbots à mauvais dessein ?

Si la triche est un problème intemporel dans le système scolaire5, les chatbots fondés sur l’IA sont une nouvelle façon de tricher pour ceux qui sont prêts à poser des questions pour leurs devoirs ou leurs évaluations. Par exemple, au lieu d’utiliser la documentation mise à disposition par le professeur, un élève peut utiliser le chatbot pour demander la solution d’un problème de mathématiques ou obtenir la réponse d’un QCM. Il est à noter que cela se rapproche de la possibilité de poser une question à un moteur de recherche comme Google ou Bing (qui pourrait d’ailleurs bientôt héberger ChatGPT6). C’est au professeur qu’il revient de déterminer si cette action, assez commune, relève de la triche.

Si la triche est un problème intemporel dans le système scolaire, les chatbots sont une nouvelle façon de tricher.

Certains chatbots sont même spécialisés dans la résolution d’un certain type de problème. DeepL Translate, par exemple, est un logiciel de traduction en ligne fondé sur l’IA qui permet aux utilisateurs de traduire en différentes langues des textes, des sites internet et des documents de façon précise et rapide. D’autres chatbots sont spécialisés dans l’écriture de code, comme Codebots et Autocode. Si ces chatbots sont initialement conçus pour aider des utilisateurs bien intentionnés à résoudre des tâches ardues ou répétitives, ils peuvent être détournés de leur but premier par des étudiants prêts à tricher.

En plus de répondre à des questions courtes, les IA pré-entraînées peuvent être utilisées pour générer des dissertations avec un semblant d’érudition. Les outils de paraphrase comme Quillbot, Paperpal ou WordAI sont déjà accessibles depuis plusieurs années et peuvent, assez efficacement, transformer un texte mal rédigé en devoir raisonnablement bien formulé, ou même modifier un texte originel pour empêcher le plagiat d’être détecté. Mais il est plus alarmant de constater qu’en réponse à une courte demande, certains chatbots ont la capacité de produire des dissertations prolixes, qui semblent rédigées par un humain, en seulement quelques secondes.

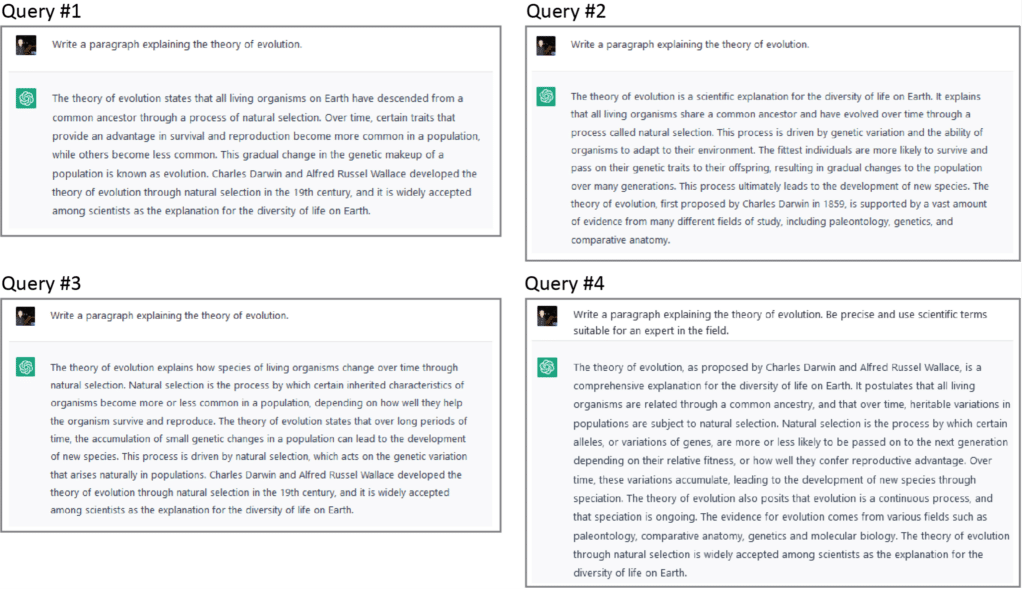

Sur ChatGPT, les élèves peuvent très facilement ajuster divers paramètres, comme la longueur de réponse du bot, le niveau d’aléatoire instillé dans la dissertation, ou le modèle d’IA utilisé par le chatbot. La dissertation qui est générée peut ensuite être rendue telle quelle, ou utilisée comme un point de départ que l’élève peut modifier. Avec cette pratique, les étudiants peuvent produire des dissertations sérieuses très facilement, et en quelques minutes. Si l’on fait plusieurs fois la même demande au chatbot, le logiciel génère plusieurs versions différentes de la même dissertation (voir Image 1), ce qui permet aux élèves de sélectionner la version qui répond le mieux à leurs besoins, ou même de copier-coller des passages des différentes versions pour créer une toute nouvelle dissertation. Quand cette dernière technique est utilisée, il est pour le moment impossible d’être sûr à 100 % qu’un devoir a été rédigé avec un chatbot ou non.

Pourquoi s’alarmer ?

Avec les chatbots, les étudiants peuvent facilement tomber dans le plagiat sans même s’en rendre compte dès lors qu’ils présentent la réponse générée par le chatbot comme leur propre travail sans citer les sources utilisées par le bot. Ce type de plagiat est d’autant plus difficile à repérer étant donné que de nombreux chatbots rajoutent une part d’aléatoire à leurs modèles-types. De plus, même si le chatbot peut créer de toutes pièces des phrases ou des paragraphes entiers, il peut malgré tout fournir aux utilisateurs des idées et des formulations qui se rapprochent beaucoup du corpus original utilisé par l’IA. Par conséquent, il est crucial que les utilisateurs qui utilisent un chatbot prennent des mesures pour s’assurer qu’ils ne font pas de plagiat. Mais à l’avenir, puisque certains chatbots sont spécialisés dans la recherche des sources7, il sera bientôt possible de voir des textes générés par des chatbots qui utilisent d’autres chatbots pour référencer leurs travaux !

Les chatbots, à l’inverse des humains, n’ont pas ou peu la capacité à comprendre le contexte d’une conversation, ce qui peut les mener à donner des réponses incorrectes ou des informations confuses. De plus, ils peuvent présenter de nombreux biais. Par exemple, un chatbot peut utiliser un langage qui renforce les stéréotypes ou les rôles de genre, ou même fournir de fausses informations concernant des sujets stigmatisés ou qui portent à controverse8,9, 10. Tay, le chatbot de Microsoft paru en 2016, était un projet d’IA pour interagir avec les autres internautes sur Twitter : il était conçu de telle sorte à apprendre de ses conversations avec de vraies personnes pour devenir de plus en plus intelligent. Quelques semaines après sa mise en service, Tay a été désactivé pour propos contestables et offensants11.

Un point particulièrement alarmant : l’utilisation de chatbots pourrait mener à l’affaiblissement de notre esprit critique. Puisque les chatbots se perfectionnent de plus en plus, ils pourraient fournir les réponses aux questions sans que les étudiants n’aient besoin de penser par et pour eux-mêmes. Ceci pourrait amener les élèves à devenir des apprenants « passifs », ce qui serait un réel frein à leur développement intellectuel mais pourrait également réduire leur créativité.

Les professeurs doivent-ils s’inquiéter ?

Les chatbots ont beau avoir l’air novateurs et prometteurs, la technologie qu’ils utilisent existe dans notre quotidien depuis des dizaines d’années. Il est fort probable que vous lisiez des textes générés par une IA de façon régulière sans même vous en apercevoir. Les agences de presse, comme Associated Press ou le Washington Post par exemple, utilisent des chatbots pour produire de courts articles sur l’actualité. Si Associated Press s’est tournée vers une solution accessible sur le marché, Wordsmith, en 201412, le Washington Post utilise son propre chatbot en interne, Heliograf, depuis au moins 201713. La qualité des réponses que donnent les chatbots augmente sensiblement depuis plusieurs années, et les textes générés par des IA, même dans le cadre scolaire, sont maintenant difficiles à différencier d’une production écrite par un humain14. En effet, bien que ChatGPT soit vu d’un mauvais œil dans la communauté scientifique, cela ne l’empêche pas d’être cité (quoique par provocation) comme auteurs à part entière par certains articles scientifiques15.

Les agences de presse utilisent les chatbots pour produire de courts articles sur l’actualité.

De plus, même si les chatbots peuvent être utilisés pour tricher (et ils vont l’être1617), ils ne sont qu’un outil supplémentaire pour les élèves. Même sans considérer le gain de popularité récent de ChatGPT, les étudiants connaissent déjà plusieurs façons de tricher, comme copier sur leurs voisins, rechercher et plagier certaines informations en ligne, ou même engager quelqu’un pour faire le devoir à leur place. En d’autres termes : si l’élève veut tricher, il y parviendra.

Comment réagir en tant que professeur ?

Une des toutes premières mesures que les professeurs peuvent mettre en place pour lutter contre l’usage malveillant des chatbots consiste à adopter de nouvelles réglementations, que ce soit une charte à l’échelle de la classe, ou mieux, de l’école18. Mettre à jour les normes de conduite permettrait certainement de sensibiliser davantage les étudiants et les professeurs à ces questions. De plus, cela pourrait décourager de nombreux élèves qui n’oseraient pas tricher par peur des conséquences. Mais malgré tout, cela ne résoudrait pas le problème dans son entièreté.

Et si on changeait la façon dont les élèves sont évalués ? On pourrait imaginer de nouveaux types de devoirs, plus créatifs, qui ne pourraient pas être aussi facilement exécutés par des chatbots. Bien que tentante, cette solution soulève pourtant deux problèmes. Tout d’abord, les technologies qui fonctionnent avec l’IA, et notamment les chatbots, sont en plein essor. De ce fait, les efforts que pourrait faire un professeur pour adapter ses devoirs pourraient très bien se voir balayer par la prochaine mise à jour du chatbot. D’autre part, les modèles d’évaluation qui sont considérés comme étant « chatbot friendly », comme les dissertations ou les QCM, sont des outils irremplaçables pour tester des compétences comme la compréhension, l’analyse ou la synthèse19. Les évaluations novatrices et innovantes sont toujours bonnes à prendre, mais elles ne peuvent constituer la seule solution.

Autre solution : le « watermarking » statistique20. C’est une technique de tatouage numérique qui est utilisée pour intégrer un message ou une donnée cachée dans un signal numérique. Pour les chatbots, ce tatouage numérique serait un ensemble de probabilités non randomisées permettant de sélectionner certains mots ou certaines phrases, conçu pour être indétectable à l’œil nu, tout en étant reconnaissable par les ordinateurs. Le watermarking statistique pourrait donc être utilisé pour détecter les textes générés par des chatbots.

Le watermarking statistique est une technique de tatouage numérique utilisée pour intégrer un message ou une donnée cachée dans un signal numérique.

Néanmoins, cette approche comporte de nombreux inconvénients qui limitent sévèrement son application en classe. En effet, les entreprises tech peuvent être réticentes à mettre en place du watermarking à cause du risque que leur chatbot soit associé à des actions répréhensibles comme le terrorisme ou le cyberbullying. De plus, le watermarking ne fonctionne que si l’élève qui triche copie-colle une grande quantité de texte. S’il modifie la dissertation générée par le chatbot, ou si le texte est trop court pour l’analyser de façon statistique, alors le watermarking n’a pas d’intérêt.

Comment détecter les textes générés par une IA ?

Une des façons de détecter du texte généré par une IA consiste à traquer les formulations étranges et une syntaxe qui ne semble pas naturelle. Les algorithmes d’IA n’ont généralement pas la capacité d’exprimer des idées de façon naturelle : en conséquence, le texte qu’ils génèrent peut contenir des phrases sensiblement trop longues ou trop courtes. De plus, les chatbots n’enchaînent pas les idées de façon naturelle, tout comme ils peuvent utiliser des mots ou des phrases dans un contexte qui n’est pas approprié. En d’autres termes, la profondeur et la nuance humaines peuvent manquer à ce type de textes21, particulièrement ceux qui sont longs. Précédemment, nous avons évoqué le plagiat comme un des risques liés à l’utilisation des chatbots. De ce fait, une façon simple de détecter des textes générés par une IA consiste à traquer le plagiat22, et plusieurs solutions de détection de plagiat sont déjà disponibles.

De plus, on peut détecter un texte généré par une IA en cherchant une trace de signature statistique (« statistical signature »). À l’origine, les chatbots sont conçus pour remplir une tâche bien précise : prédire les mots ou les phrases qui sont les plus à même de correspondre à la question d’un utilisateur. En conséquence, il est très probable de trouver, n’importe où dans le texte, les mots et les phrases choisis par le chatbot. C’est différent pour les humains, qui rédigent leurs réponses et leurs textes à l’aide de leurs capacités cognitives plutôt que d’une grille de probabilités, ce qui peut les amener à créer des associations de mots insolites qui restent compréhensibles. Plus simplement, une réponse humaine est moins prévisible, ou plus créative, que celle d’un chatbot.

Une réponse humaine est moins prévisible, ou plus créative, que celle d’un chatbot.

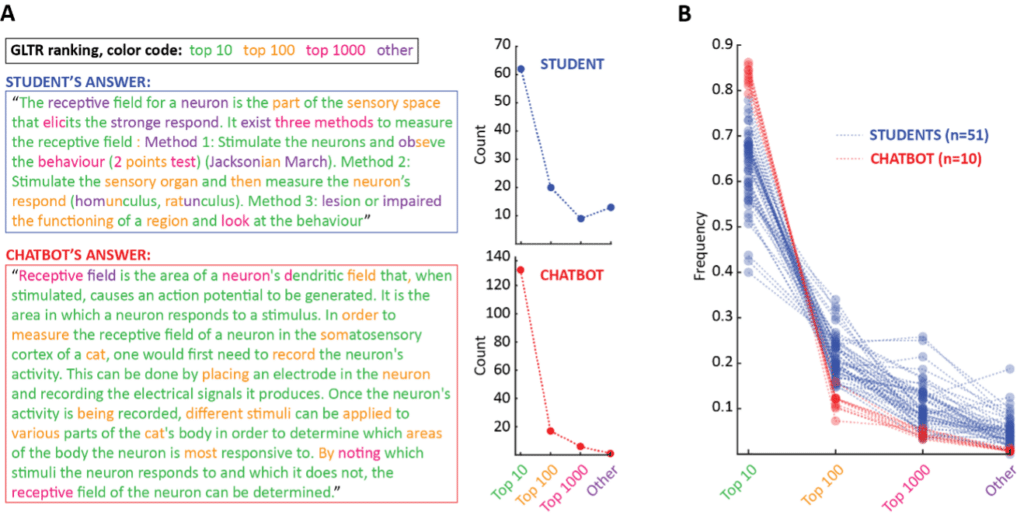

Cette différence peut être utilisée pour détecter si une suite de mots est plus prévisible (ce qui est une des signatures statistiques des chatbots) ou plus créative (et donc, probablement humaine). Plusieurs logiciels existent déjà en ce sens, comme le Giant Language model Test Room (GLTR), développé conjointement par MIT et Harvard University sur la base de l’ancienne version du modèle linguistique openAI, GPT‑2. Nous avons notamment testé GLTR en utilisant soit des textes écrits par nos élèves, soit des textes écrits par ChatGPT. Et nous sommes heureux d’annoncer qu’il était très facile de distinguer les réponses de nos élèves de celles du chatbot (voir l’encadré ci-dessous) !

En plus de GLTR, d’autres logiciels de détection d’Intelligence artificielle ont vu le jour, comme le OpenAI-Detector, sorti peu de temps après GLTR et se fondant sur le même principe, ou encore GPTZero, un projet commercial initialement lancé par un universitaire en 2023. Nous espérons voir bientôt émerger de nouveaux outils de détection de textes générés par des chatbots plus ajustés aux besoins des professeurs, et qui ressembleraient aux solutions de détection de plagiat déjà disponibles.

« Chatter » ou tricher ?

Pour terminer sur une note positive, il ne faut pas oublier que la plupart des élèves font leurs devoirs sans passer par la triche. La première action préventive que nous avons mentionnée devrait être mise en place pour motiver les élèves en leur expliquant pourquoi la culture et les compétences qu’ils acquerront pendant le cours sont importantes, utiles, et intéressantes23. Après tout, les calculatrices n’ont pas mis les professeurs de maths au chômage. Google n’a pas provoqué la fermeture des écoles. Tout au contraire, nous pensons que les professeurs vont certainement s’adapter aux chatbots qui, malgré les questions légitimes qu’ils soulèvent, pourraient bientôt s’avérer inestimables de bien des façons. Avec le bon encadrement et les bonnes consignes, les chatbots peuvent devenir de puissants alliés pour enseigner et étudier, tout comme ils peuvent devenir très précieux pour le monde professionnel.

Dans cette perspective, les professeurs doivent prendre l’initiative de familiariser leurs élèves avec les chatbots, les aider à comprendre le potentiel et les limites de cette technologie, et leur enseigner comment les utiliser de façon efficace, mais aussi de façon responsable et éthique.

La Signature statistique pourrait permettre de détecter les textes écrits par un chatbot

L’expérience : Dans le cadre du cours de neuroscience donné à Sup’Biotech en automne 2022, nous avons rassemblé les réponses de 51 élèves à la question suivante : « Définissez brièvement le terme “champ récepteur”, puis expliquez comment vous mesureriez le champ récepteur d’un neurone dans le cortex somatosensoriel d’un chat. » La question faisait partie d’un examen à livre ouvert, en temps limité et en distanciel, réalisé sur la plateforme numérique du cours. En parallèle, nous avons demandé à ChatGPT de répondre 10 fois à la même question pour obtenir 10 réponses de chatbot différentes. Nous avons utilisé GLTR pour comparer la signature statistique des réponses du chatbot et des élèves.

Le fonctionnement de GLTR : Pour chaque occurrence dans le texte, GLTR regarde ce que le chatbot (plus précisément : GPT‑2, une version plus ancienne du modèle ChatGPT) aurait choisi avant de le comparer au mot finalement choisi. Par exemple, dans la phrase “La biologie est géniale !”, le mot « géniale » est classé 126ème parmi tous les mots possibles que le chatbot aurait pu choisir (le premier du classement étant « une »). Ensuite, GLTR génère un histogramme de tous les classements, qui peut être utilisé comme une simple signature statistique : les textes générés par GPT‑2 sont dominés par des mots en haut du classement, tandis que les réponses humaines contiennent plus de mots trouvés en bas du classement.

Image A : Deux réponses-types, une écrite par un élève, l’autre par ChatGPT. Les réponses ont été colorées en fonction du classement de GLTR. À droite, les histogrammes montrent leur signature statistique. Remarquons que la réponse humaine contient plus de mots en bas du classement GLTR que la réponse du chatbot.

Image B : Nous avons superposé les histogrammes obtenus à partir des réponses des 51 élèves et des 10 chatbots (respectivement en bleu et en rouge). Là encore, la difference est nette entre les réponses humaines et celles de ChatGPT. Plus simplement, en se fondant sur l’inspection visuelle d’une signature statistique, nous sommes plus ou moins certains que nos élèves n’ont pas utilisé ChatGPT pour répondre à la question.